-

Mitspieler gesucht? Du willst dich locker mit der Community austauschen? Schau gerne auf unserem ComputerBase Discord vorbei!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Fortnite-Benchmarks (2024): 28 GPUs von AMD, Intel & Nvidia in FHD, WQHD & UHD im Test

Moritz Velten

Lieutenant

- Registriert

- März 2020

- Beiträge

- 755

Pro_Bro schrieb:230 Millionen aktive Spieler monatlich.

Oh, danke.

War mir gar nicht so bewusst, da man davon gar nicht mehr so viel in den Medien liest und hört.

unspektakulaer

Cadet 4th Year

- Registriert

- Juli 2015

- Beiträge

- 66

Mein Neffe spielt Fortnite auf nem 10er i5 und ner GTX 560 Ti. Wenn man will läuft das Game sogar auf nem Toaster. ^^

Aber krass das AMD hier so stark abschneidet, hätte ich nicht erwartet.

Aber krass das AMD hier so stark abschneidet, hätte ich nicht erwartet.

- Registriert

- Juli 2021

- Beiträge

- 2.255

Montag Morgen, frisch gestärkt und auf die Freigabe der Datenbank wartend:

Ich persönlich sehe das Thema mit FSR, TSR und DLSS an der Stelle anders als du und denke eben nicht, dass man hier FSR Quality gegen DLSS Balanced antreten lassen sollte, weil FSR Quality "pauschal" von der Qualität nur DLSS Balanced entsprechen würde.

Und da fängt das Problem an: Definiere Bessere. Und bitte kommt jetzt nicht damit, dass man ein Bild Pixel für Pixel vergleichen soll. Da kann man Farbunterschiede erkenne, das war es dann schon. Und was nimmt man als Referenz? Nativ, dass je nach Spiel bereits nachweißlich schlechter aussehen kann als FSR und DLSS?

An dieser Stelle kann man - und auch das ist legitim - einen pragmatischeren Ansatz wählen und sagen, dass die Upscaling-Einstellung wählt, die das gleiche Rendertarget und damit die "best mögliche" Bildqualität gewährleistet wird, auch wenn diese dann zwischen den Karten unterschiedlich ist.

Es ist alles eine Frage des Standpunktes und jede Meinung ist hier valide. Es gibt hier kein wirklich "besser" oder "schlechter", sondern nur ein: anders.

Es zeigt sich ja in vielen Spielen, dass gerade in 1080p die RTX 4090 starke Probleme hat ihre Shader auszulasten - zu viele Warps die benötigt werden. Ab 1440p - gerade mit RT - tritt da Besserung ein, in der Regel benötigt es aber 4K, damit die RTX 4090 überhaupt die geballte Rechenleistung irgendwie auf den Bildschirm bringt.

Daher verliert man ja in 1440p kaum fps, selbst wenn man die RTX 4090 von 450 W auf 300 - 320 W einbremst.

Ich kann es durchaus verstehen, dass manche den Ansatz, den wir hier fahren, nicht perfekt finden, was RT angeht oder eben in 4K nun FSR/DLSS/XeSS "Quality" zu aktivieren. Es geht hier um ein Ranking und in dem kann es manchmal durchaus auch relevant sein, einfach mit maximierten Settings die Benches laufen zu lassen, um die Unterschiede zwischen den Grafikkarten deutlicher zu machen. Ähnlich verhält es sich ja auch mit der CPU.

Das ist auch in dem Fall eine valide Sichtweise, die ohne jedes Wenn und Aber, auch ihre Berechtigung hat.

Ich zitiere meine Professorin: "Es kommt darauf an."

Im Endeffekt ist das, was wir hier machen, auch nur ein Blickwinkel auf die Leistung der Grafikkarten. Es gibt allerdings viele andere Zeitschriften, Techseiten, YouTuber und Co, die die Grafikkarten vermessen und die auch andere Schwerpunkt dabei wählen.

Wir alle wählen unterschiedliche Testszenarien mit unterschiedlicher Länge, wir haben alle unterschiedliche Systeme. Mal "Standard", mal "Optimiert". Mal ist die Testsequenz 30 Sekunden, mal 60 Sekunden. Manche testen im absoluten Worst-Case, andere wählen eher Durchschnitt und so weiter.

Das ist auch gut so, weil man so über verschiedene Medien ein möglichst bereits Bild von den Grafikkarten bekommt oder eben der CPU.

Genauso sollte man Themen wie Serienstreuung - was Lüfter angeht und Co - nicht unterschätzen und kann auch so sehen, ob vielleicht Probleme bestehen.

Wenn alleine die RTX 4090 im Stande wäre in 4K knapp 30 fps zu erreichen, dann nutzt es fast nichts, wenn die 4080 und 7900 XTX bei 24 - 25 fps sind und alle anderen Grafikkarten noch darunter.

In so einem Fall kann es durchaus sinnvoll sein, auch bei einem großen Test, die Settings so zu wählen, dass alle Grafikkarten halbwegs über 30 fps kommen. In der den meisten Fällen bilden sich nämlich auch in anderen Einstellungen die üblichen Abstände ein. Wenn dann die 4080 und 7900 XTX auf 50 fps kommen, landet die RTX 4090 in der Regel bei 60 - 70 fps.

Es ist immer ein zweischneidiges Schwert. Das ganze Thema ist weit aus komplexer, als einfach nur ein Summenspiel.

Wichtig ist - und das ist der Knackpunkt - dass offen darüber gesprochen wird und transparent die Umstände der Benchmarks erläutert werden.

Es sind alle Informationen dafür vorhanden.

Man kann an dieser Stelle unendlich viel sagen und am Ende kann jeder dazu eine Meinung haben, das macht die anderen Meinungen an der Stelle nur weder weniger richtig noch weniger falsch.Taxxor schrieb:Man könnte natürlich sagen, wenn alle GPUs mit FSR verglichen werden, bekommt man ein faireres Ergebnis, weil dann die Optik auch identisch ist.

Ich persönlich sehe das Thema mit FSR, TSR und DLSS an der Stelle anders als du und denke eben nicht, dass man hier FSR Quality gegen DLSS Balanced antreten lassen sollte, weil FSR Quality "pauschal" von der Qualität nur DLSS Balanced entsprechen würde.

Das wäre es in diesem Fall in deinen Augen. Problemematisch ist nur, dass in 4K FSR Quality je nach Titel mit DLSS Quality mithalten kann und man dann entscheiden müsste, ob jetzt DLSS wirklich die bessere Bildqualität liefert.Taxxor schrieb:Zumindest wäre es aber schon mal etwas besser, als FSR Quality gegen DLSS Quality antreten zu lassen

Und da fängt das Problem an: Definiere Bessere. Und bitte kommt jetzt nicht damit, dass man ein Bild Pixel für Pixel vergleichen soll. Da kann man Farbunterschiede erkenne, das war es dann schon. Und was nimmt man als Referenz? Nativ, dass je nach Spiel bereits nachweißlich schlechter aussehen kann als FSR und DLSS?

An dieser Stelle kann man - und auch das ist legitim - einen pragmatischeren Ansatz wählen und sagen, dass die Upscaling-Einstellung wählt, die das gleiche Rendertarget und damit die "best mögliche" Bildqualität gewährleistet wird, auch wenn diese dann zwischen den Karten unterschiedlich ist.

Es ist alles eine Frage des Standpunktes und jede Meinung ist hier valide. Es gibt hier kein wirklich "besser" oder "schlechter", sondern nur ein: anders.

Wobei man bei Fortnite auch bei 1080p weitgehend ein CPU-Limit hier ausschließen kann, wenn ich mir die Einstellungen in "Mittel" ansehe und hier plötzlich über 200 fps möglich sind.Taxxor schrieb:[...] ein CPU Limit haben, was dann mit DLSS von der 4090 erreicht wird

Es zeigt sich ja in vielen Spielen, dass gerade in 1080p die RTX 4090 starke Probleme hat ihre Shader auszulasten - zu viele Warps die benötigt werden. Ab 1440p - gerade mit RT - tritt da Besserung ein, in der Regel benötigt es aber 4K, damit die RTX 4090 überhaupt die geballte Rechenleistung irgendwie auf den Bildschirm bringt.

Daher verliert man ja in 1440p kaum fps, selbst wenn man die RTX 4090 von 450 W auf 300 - 320 W einbremst.

So, jetzt muss ich auch mal die andere Seite einnehmen, weil ich "neutral" bin.PeacemakerAT schrieb:Und was bringt es Spiele nur nativ und nur in Ultra zu benchen, wenn dann oftmals nur die 4090 sinnvolle Bildraten schafft?

Ich kann es durchaus verstehen, dass manche den Ansatz, den wir hier fahren, nicht perfekt finden, was RT angeht oder eben in 4K nun FSR/DLSS/XeSS "Quality" zu aktivieren. Es geht hier um ein Ranking und in dem kann es manchmal durchaus auch relevant sein, einfach mit maximierten Settings die Benches laufen zu lassen, um die Unterschiede zwischen den Grafikkarten deutlicher zu machen. Ähnlich verhält es sich ja auch mit der CPU.

Das ist auch in dem Fall eine valide Sichtweise, die ohne jedes Wenn und Aber, auch ihre Berechtigung hat.

Genau, du findest es an der Stelle schlauer. Andere finden es weniger schlau und ich mag das Wort Schlau an der Stelle nicht, weil es direkt wertend ist.PeacemakerAT schrieb:Da finde ich den Ansatz den CB gewählt hat viel schlauer, das sind Settings wie viel hier sie auch in Realität anwenden werden.

Ich zitiere meine Professorin: "Es kommt darauf an."

Genau, man kann, muss aber nicht.Taxxor schrieb:Alles andere ist rein akademischer Natur, das kann man in gezielten groß angelegten GPU Testartikeln machen, wo es wirklich gar nicht so sehr um die einzelnen Spiele sondern ums Ranking generell geht, aber es ist nicht sinvoll für einzelne Spiele-Tests.

Im Endeffekt ist das, was wir hier machen, auch nur ein Blickwinkel auf die Leistung der Grafikkarten. Es gibt allerdings viele andere Zeitschriften, Techseiten, YouTuber und Co, die die Grafikkarten vermessen und die auch andere Schwerpunkt dabei wählen.

Wir alle wählen unterschiedliche Testszenarien mit unterschiedlicher Länge, wir haben alle unterschiedliche Systeme. Mal "Standard", mal "Optimiert". Mal ist die Testsequenz 30 Sekunden, mal 60 Sekunden. Manche testen im absoluten Worst-Case, andere wählen eher Durchschnitt und so weiter.

Das ist auch gut so, weil man so über verschiedene Medien ein möglichst bereits Bild von den Grafikkarten bekommt oder eben der CPU.

Genauso sollte man Themen wie Serienstreuung - was Lüfter angeht und Co - nicht unterschätzen und kann auch so sehen, ob vielleicht Probleme bestehen.

Was wiederum nicht schlecht sein muss, es kommt halt darauf an, worum es dabei geht.MoinWoll schrieb:Das Problem ist allerdings, dass CB mittlerweile auch die großen Grafikkartentestartikel, in denen es wirklich darum geht, die tatsächliche Leistung von Grafikkarten relativ zueinander über eine große Anzahl Spiele zu bestimmen, mit reduzierten Settings durchführt.

Wenn alleine die RTX 4090 im Stande wäre in 4K knapp 30 fps zu erreichen, dann nutzt es fast nichts, wenn die 4080 und 7900 XTX bei 24 - 25 fps sind und alle anderen Grafikkarten noch darunter.

In so einem Fall kann es durchaus sinnvoll sein, auch bei einem großen Test, die Settings so zu wählen, dass alle Grafikkarten halbwegs über 30 fps kommen. In der den meisten Fällen bilden sich nämlich auch in anderen Einstellungen die üblichen Abstände ein. Wenn dann die 4080 und 7900 XTX auf 50 fps kommen, landet die RTX 4090 in der Regel bei 60 - 70 fps.

Darüber kann man nachdenken, wäre am Ende aber dann FSR und würde auch wieder Kritik hervorbringen.HAse_ONE schrieb:Evtl sollte man aber wirklich, wenn vorhanden, auf allen Karten den gleichen Upscaler nutzen für die Vergleichbarkeit.

Muss es schlechter aussehen? Genauso: Fällt es beim Spielen auf?Taxxor schrieb:Dann muss ich für den Leistungsvergleich auch DLSS Balanced gegen TSR Quality stellen oder im Fazit erwähnen dass AMD zwar schneller ist, aber dabei schlechter aussieht

Es ist immer ein zweischneidiges Schwert. Das ganze Thema ist weit aus komplexer, als einfach nur ein Summenspiel.

Wichtig ist - und das ist der Knackpunkt - dass offen darüber gesprochen wird und transparent die Umstände der Benchmarks erläutert werden.

Es sind alle Informationen dafür vorhanden.

Taxxor

Fleet Admiral

- Registriert

- Mai 2011

- Beiträge

- 19.309

Nein, muss es nicht, das muss eben von Spiel zu Spiel betrachtet werden.DevPandi schrieb:Muss es schlechter aussehen? Genauso: Fällt es beim Spielen auf?

Hier ist es z.B. gleichwertig, woanders dann nicht mehr.

Und wenn ich in einem Spieletest die Dicke Überschrift lese „Upscaler X klar besser als Upscaler Z“(was man hier durchaus öfter mal liest), dann gehört der Umstand auch beim Leistungsvergleich mit rein.

Wenn wir nun mit dem Argument kommen, der Unterschied fällt beim Spielen eh nicht auf, dann können wir das professionelle Testen auch gleich sein lassen und zur Gamestar gehen

Zuletzt bearbeitet:

PeacemakerAT

Commander

- Registriert

- Dez. 2018

- Beiträge

- 2.380

Ja das mag wohl nicht das passendste Wort gewesen sein, was ich damit meinte war aber ziemlich das selbe was du selbst unten aufgeführt hast. Es bringt einfach nicht viel die Settings so hoch zu schrauben, um dann nur noch einen 4090 mit spielbaren FPS zu haben.DevPandi schrieb:Genau, du findest es an der Stelle schlauer. Andere finden es weniger schlau und ich mag das Wort Schlau an der Stelle nicht, weil es direkt wertend ist.

Gibt sicher auch Leute die das interessant finden würden, aber es ist halt weit entfernt davon wie dann in Wirklichkeit gespielt wird.

Die Diskussion mit den Upscalern finde ich ehrlich gesagt ziemlich müßig, die Technik ist definitiv gekommen um zu bleiben und hat je nach Umsetzung und Auflösung sogar das schönere Bild als nativ gerendert.

Wenn man jetzt bei den Benchmarks dann auch noch die Upscaling Qualität mitbetrachten würde, dann würde der Aufwand dies zu Ermitteln die Benchmarks noch viel zeitintensiver machen und wäre am Schluss trotzdem nur eine subjektive Bewertung.

Wer sagt denn, dass sich bei einem Updates des Spiels/Upscalers nicht wieder alles ändert? Da finde ich die Wahl über den Skalierungsfaktor noch am praktikabelsten, auch wenn da FSR vielleicht nicht ganz das selben Qualitätsniveau erreicht bei kleinen Auflösungen.

hennich

Lieutenant

- Registriert

- Jan. 2004

- Beiträge

- 539

Entschuldige bitte das ich den Fakten von Computerbase glaub. Deine Alternativen Fakten scheinen da wohl etwas genauer muhahahaH6-Mobs schrieb:Hört doch mal bitte auf so einen Quatsch zu erzählen. Nicht nur das es wehtut, so etwas zu lesen, nein, viel schlimmer noch, jemand anderes liest das und glaubt das noch.

H6-Mobs

Ensign

- Registriert

- Jan. 2023

- Beiträge

- 251

Welche Fakten?hennich schrieb:Entschuldige bitte das ich den Fakten von Computerbase glaub

Das die Karten in unterschiedlichen spielen unterschiedlich performen ? Achso ja, wusste nicht das du so ahnungslos bist. Entschuldige bitte.

Hier ein bisschen Lektüre für dich, vielleicht hilft es dir ja ein wenig.

https://www.pcgameshardware.de/Gefo...4090-vs-7900-XTX-Benchmark-Test-2024-1442362/

@Wolfgang

Finde es klasse, dass „meine" 6500 XT mitgetestet wurde, obwohl die unter CBlern ja wohl nur eine Handvoll haben dürften, wenn überhaupt. Danke dafür!

Fortnite & Co sind zwar nicht meins, dennoch bietet mir der Vergleich einen guten Orientierungspunkt. Bisher musste ich bei dem, was ich zocke – z. Z. RDR2 vom PC über die Wii U auf den Fernseher gestreamt – noch nichts links von der Mitte einstellen. Abwechselnd dann noch Zelda: Twilight Princess HD von der Wii U, bin also in beiden Welten unterwegs, aber anscheinend bin ich verglichen mit der Mehrheit sowieso genügsam was Grafikpower betrifft Solange die Karte abliefert, denke ich tatsächlich nicht ans Aufrüsten.

Solange die Karte abliefert, denke ich tatsächlich nicht ans Aufrüsten.

Finde es klasse, dass „meine" 6500 XT mitgetestet wurde, obwohl die unter CBlern ja wohl nur eine Handvoll haben dürften, wenn überhaupt. Danke dafür!

Fortnite & Co sind zwar nicht meins, dennoch bietet mir der Vergleich einen guten Orientierungspunkt. Bisher musste ich bei dem, was ich zocke – z. Z. RDR2 vom PC über die Wii U auf den Fernseher gestreamt – noch nichts links von der Mitte einstellen. Abwechselnd dann noch Zelda: Twilight Princess HD von der Wii U, bin also in beiden Welten unterwegs, aber anscheinend bin ich verglichen mit der Mehrheit sowieso genügsam was Grafikpower betrifft

Taxxor

Fleet Admiral

- Registriert

- Mai 2011

- Beiträge

- 19.309

Die einzigen Fakten, die CB hier zeigt, sind Benchmarks eines einzelnen Spiels, wie leitest du daraus irgend einen Treiberfortschritt oder einen generellen Fortschritt ab?hennich schrieb:Entschuldige bitte das ich den Fakten von Computerbase glaub. Deine Alternativen Fakten scheinen da wohl etwas genauer muhahaha

Dazu passen heute die nächsten Fakten von CB. Schon krass, wie weit AMD mittlerweile zurückgefallen ist, müsstest du ja nun eigentlich sagen, oder?

https://www.computerbase.de/2024-04/pubg-battlegrounds-benchmark-test-2024/

hennich

Lieutenant

- Registriert

- Jan. 2004

- Beiträge

- 539

Weißt, ich hab immer noch die 5700XT in meinem Rehcner den ich mir 2020 zusammengebaut hab.

Schon komisch das nVidia hier so ein Vorteil hat. Auch die nVidia Aktie einfach nur ganz weit weg von der REalität. Die Fanboys und ihre Interessen. WAS ERDREISSTE ICH MICH HIER SOETWAS KUND ZU TUN! Fehlt noch, Taxxor.

Die Preise - es gehören immer zwei dazu. Einer der es anbietet und einer der es kauft. Dann noch den der seine über 1000 euro GFX Karte im Forum als Schnäppchen anpreist - oh lol. Oder den der nVidia Aktien gekauft hat und JA WOHL KLAR IST DAS NVIDIA HIER PESTE IST EINZ ELF!!1

Das Erinnert mich an meinen Nachbarn aus der Türkei. Kein Geld. Mit 5 Leuten in 3 Zimmer wohnen aber der AMG steht vor der Tür. Inklusive nicht wissen was AMG heißt. Es ist so einfach Verrückte aber auch unheimlich Lustige Zeit

Schon komisch das nVidia hier so ein Vorteil hat. Auch die nVidia Aktie einfach nur ganz weit weg von der REalität. Die Fanboys und ihre Interessen. WAS ERDREISSTE ICH MICH HIER SOETWAS KUND ZU TUN! Fehlt noch, Taxxor.

Ergänzung ()

So siehts aus.Melmoth schrieb:@Wolfgang

Finde es klasse, dass „meine" 6500 XT mitgetestet wurde, obwohl die unter CBlern ja wohl nur eine Handvoll haben dürften, wenn überhaupt. Danke dafür!

Fortnite & Co sind zwar nicht meins, dennoch bietet mir der Vergleich einen guten Orientierungspunkt. Bisher musste ich bei dem, was ich zocke – z. Z. RDR2 vom PC über die Wii U auf den Fernseher gestreamt – noch nichts links von der Mitte einstellen. Abwechselnd dann noch Zelda: Twilight Princess HD von der Wii U, bin also in beiden Welten unterwegs, aber anscheinend bin ich verglichen mit der Mehrheit sowieso genügsam was Grafikpower betrifftSolange die Karte abliefert, denke ich tatsächlich nicht ans Aufrüsten.

Die Preise - es gehören immer zwei dazu. Einer der es anbietet und einer der es kauft. Dann noch den der seine über 1000 euro GFX Karte im Forum als Schnäppchen anpreist - oh lol. Oder den der nVidia Aktien gekauft hat und JA WOHL KLAR IST DAS NVIDIA HIER PESTE IST EINZ ELF!!1

Das Erinnert mich an meinen Nachbarn aus der Türkei. Kein Geld. Mit 5 Leuten in 3 Zimmer wohnen aber der AMG steht vor der Tür. Inklusive nicht wissen was AMG heißt. Es ist so einfach Verrückte aber auch unheimlich Lustige Zeit

SonyFriend

Lt. Commander

- Registriert

- Jan. 2006

- Beiträge

- 1.764

Danke für den Test, haben wir gerne gelesen.

Wir? Ja, wir spielen Fortnite im Team.

Alter: 25 - 40 - 55 - 65

Macht immer wieder Spaß, so ein Game mit verschiedenen:

Charakteren / Hardware / Ansprüchen

zu spielen.

Performance bzw, FPS interessiert nicht jeden, aber wir spielen 2 x AMD und 2 x nvidia

Wir? Ja, wir spielen Fortnite im Team.

Alter: 25 - 40 - 55 - 65

Macht immer wieder Spaß, so ein Game mit verschiedenen:

Charakteren / Hardware / Ansprüchen

zu spielen.

Performance bzw, FPS interessiert nicht jeden, aber wir spielen 2 x AMD und 2 x nvidia

hennich

Lieutenant

- Registriert

- Jan. 2004

- Beiträge

- 539

Hab Fortnite am ersten Tag wo es Released wurde gezockt. Ohgott wie furchtbar, ein PUBG Clone von EA. Die Jahre vergingen. Das Kind wünschte sich seit 4 Monaten das wir zusammen Fortnite spielen. Jetzt hab ich mein Geschäftskollegen gesagt er soll jetzt einfach die Klappe halten was ich sag und einfach TUN was ich sag. Installiers und halt die Klappe wir spielen das jetzt. Unser Fortnite Team 45 - 45 - 12

Verdammt, es macht echt laune!

Verdammt, es macht echt laune!

heroesgaming

Lt. Commander

- Registriert

- Feb. 2022

- Beiträge

- 1.548

Er hat aber schon recht, dass die 7900 XTX in einzelnen Spielen mithält, ist nichts neues. Das ist insbesondere dann der Fall, wenn die RTX 4090 ihre Leistung nicht auf die Straße bringt. Dass es sich um zwei Grafikkarten in völlig anderen Leistungsdimensionen handelt, weiß auch AMD, ansonsten hätte man sein Flaggschiff nicht gegen die RTX 4080 positioniert. Insofern ist es in der Tat nicht sonderlich haltbar, aus einem Ergebnis in Fortnite massiven Treiberfortschritt abzuleiten. Und das sage ich als Besitzer der 7900 XTX. Man muss schließlich wissen, was man kaufthennich schrieb:Entschuldige bitte das ich den Fakten von Computerbase glaub. Deine Alternativen Fakten scheinen da wohl etwas genauer muhahaha

War doch damals auch eine solide Karte, sofern man vom Blackscreen-Problem verschont blieb. Mein Bruder war auch hochzufrieden, bis er kürzlich gewechselt ist.hennich schrieb:Weißt, ich hab immer noch die 5700XT in meinem Rehcner den ich mir 2020 zusammengebaut hab.

Und mit "hier" meinst du in der Verbreitung im Forum, der allgemeinen Marktdurchdringung, der Leistung im Top-End-Bereich? Komisch ist daran eigentlich nichts. Man hat produktpolitisch über die Jahre einfach viel richtig gemacht, konnte in Sachen Qualität einigermaßen kontinuierlich abliefern, hatte eigentlich immer die alleinige, mindestens aber geteilte Leistungsführerschaft inne, gleichzeitig passte das Marketing. In der Konsequenz ist man heute im Bereich der Consumer-GPUs in einer Apple-artigen Position, wodurch viele Kunden Nvidia als den Grafikkartenhersteller schlechthin betrachten. AMD konnte sich über die Jahre einfach nicht als gleichwertiger Konkurrent etablieren und der erneute Abstecher in die Mittelklasse für RDNA 4 zeigt dir auch ziemlich genau, warum dem so ist.hennich schrieb:Schon komisch das nVidia hier so ein Vorteil hat.

Tech-Werte werden an der Wallstreet alle in ganz anderen Sphären gehandelt, das ist eben einfach so. Inwiefern das einen relevanten Bezug zur Leistung einer Geforce in Fortnite hat, sei dahingestellt.hennich schrieb:Auch die nVidia Aktie einfach nur ganz weit weg von der REalität.

Fanboymäßig bist doch eher du mit deinem Beitrag unterwegs, oder täusche ich mich? Wie gesagt, ein einzelnes Spiel kann für die durchschnittliche Leistungsfähigkeit einer Grafikkarte schlicht nicht als aussagekräftig betrachtet werden. Es gibt immer Spiele, die einem der Hersteller besser liegen als dem anderen. Solche Ausreißer würden in einem repräsentativen Benchmark-Parcours aber eingehegt, schau' dir dazu ruhig jeden halbwegs aktuellen Test an.hennich schrieb:Die Fanboys und ihre Interessen. WAS ERDREISSTE ICH MICH HIER SOETWAS KUND ZU TUN! Fehlt noch, Taxxor.

Ergänzung ()

Ansprüche sind unterschiedlich, ebenso wie Preisvorstellungen und finanzielle Leistungsfähigkeiten.hennich schrieb:So siehts aus.

Die Preise - es gehören immer zwei dazu. Einer der es anbietet und einer der es kauft. Dann noch den der seine über 1000 euro GFX Karte im Forum als Schnäppchen anpreist - oh lol.

Weder mit 5700 XT noch mit 6500 XT kannst du sinnvoll 4K-Gaming betreiben, 1080p ist dagegen in vielen Spielen überhaupt kein Problem - wenn es dann nicht zwingend Hunderte von Frames sein sollen. Wenn ich einen 4K-OLED-Monitor kaufe und erwarte, dass meine Spiele immer und durchgängig mit 60 fps oder mehr laufen, können 1000 € für eine Grafikkarte im Marktumfeld durchaus günstig sein - oder würdest du Budget für ein Anzeigegeräte im vierstelligen Bereich einplanen, es dann aber an einen PC anschließen, der insgesamt weniger gekostet hat? Die meisten werden das wohl kaum so machen.

Wer vor einigen Jahren Nvidia-Aktien gekauft hat, dürfte damit einiges richtig gemacht haben - mit dem Thema hat das aber nach wie vor nichts zu tun. Ein vernünftiger Investor ist nicht gleich ein Fanboy.hennich schrieb:Oder den der nVidia Aktien gekauft hat und JA WOHL KLAR IST DAS NVIDIA HIER PESTE IST EINZ ELF!!1

Ein ziemlich polemischer Vergleich, da ich bezweifle, dass die meisten Besitzer teurer Grafikkarten diese auf Kosten von Annehmlichkeiten wie ausreichendem Wohnraum anschaffen - aber dabei kann ich natürlich nur von mir selbst sprechenhennich schrieb:Das Erinnert mich an meinen Nachbarn aus der Türkei. Kein Geld. Mit 5 Leuten in 3 Zimmer wohnen aber der AMG steht vor der Tür. Inklusive nicht wissen was AMG heißt. Es ist so einfach Verrückte aber auch unheimlich Lustige Zeit

hennich

Lieutenant

- Registriert

- Jan. 2004

- Beiträge

- 539

Klar, wer weiß schon das Gewisse Produkte Design Fehler haben und es auch der Treiber nicht mehr richten kann. Oder bei nVidia die Steckerverbindungen die mit der Last die grätsche gemacht haben.heroesgaming schrieb:Er hat aber schon recht, dass die 7900 XTX in einzelnen Spielen mithält, ist nichts neues. Das ist insbesondere dann der Fall, wenn die RTX 4090 ihre Leistung nicht auf die Straße bringt. Dass es sich um zwei Grafikkarten in völlig anderen Leistungsdimensionen handelt, weiß auch AMD, ansonsten hätte man sein Flaggschiff nicht gegen die RTX 4080 positioniert. Insofern ist es in der Tat nicht sonderlich haltbar, aus einem Ergebnis in Fortnite massiven Treiberfortschritt abzuleiten. Und das sage ich als Besitzer der 7900 XTX. Man muss schließlich wissen, was man kauft

Hab nichts gegenteiliges behauptet. Hab sie immer nochheroesgaming schrieb:War doch damals auch eine solide Karte, sofern man vom Blackscreen-Problem verschont blieb. Mein Bruder war auch hochzufrieden, bis er kürzlich gewechselt ist.

Nein, damit meine ich die Benchmarks. Computerbase hat nicht direkt was mit nVidia zu tun ? Ähh hä ?heroesgaming schrieb:Und mit "hier" meinst du in der Verbreitung im Forum, der allgemeinen Marktdurchdringung, der Leistung im Top-End-Bereich? Komisch ist daran eigentlich nichts

Richtig, an der Börse wird gehandelt. Absolut richtig. Da gibt es unheimlich viele vonheroesgaming schrieb:Tech-Werte werden an der Wallstreet alle in ganz anderen Sphären gehandelt, das ist eben einfach so. Inwiefern das einen relevanten Bezug zur Leistung einer Geforce in Fortnite hat, sei dahingestellt.

Es kommt darauf an wieviel man Investiert. Da kann man schon mal Privat zum Fanboy werden ( siehe Musk ) um den ganzen Monetären Nachdruck zu verleihen. Falls du im Tagesgeschäft dabei bist, hat Musk soviel Macht das er Börsen hoch und runter jagen kann. Zumindest bei allen Anlegern Verunsicherung bringen kann. Bissi mehr Interesse am Tagesgeschäft würde dieses Defizit hier glätten fyi.heroesgaming schrieb:Fanboymäßig bist doch eher du mit deinem Beitrag unterwegs, oder täusche ich mich? Wie gesagt, ein einzelnes Spiel kann für die durchschnittliche Leistungsfähigkeit einer Grafikkarte schlicht nicht als aussagekräftig betrachtet werden. Es gibt immer Spiele, die einem der Hersteller besser liegen als dem anderen. Solche Ausreißer würden in einem repräsentativen Benchmark-Parcours aber eingehegt, schau' dir dazu ruhig jeden halbwegs aktuellen Test an.

Hoffen wir es! Gut die Wirtschaft lebt auch von dummen Menschen. Soz. die Leistungsträgerheroesgaming schrieb:Ansprüche sind unterschiedlich, ebenso wie Preisvorstellungen und finanzielle Leistungsfähigkeiten.

Weder mit 5700 XT noch mit 6500 XT kannst du sinnvoll 4K-Gaming betreiben, 1080p ist dagegen in vielen Spielen überhaupt kein Problem - wenn es dann nicht zwingend Hunderte von Frames sein sollen. Wenn ich einen 4K-OLED-Monitor kaufe und erwarte, dass meine Spiele immer und durchgängig mit 60 fps oder mehr laufen, können 1000 € für eine Grafikkarte im Marktumfeld durchaus günstig sein - oder würdest du Budget für ein Anzeigegeräte im vierstelligen Bereich einplanen, es dann aber an einen PC anschließen, der insgesamt weniger gekostet hat? Die meisten werden das wohl kaum so machen.

Meine Lebenserfahrung ist hier eine andere. So scheinen Menschen aus anderen Kulturen die Priorität auf das Automobil zu legen. Das ist in diesen Ländern so. Besonders Deutsche ohne Lebenserfahrung und Kenntnisse aus dem Ausland tun sich mit dieser Erkenntnis unheimlich schwer!heroesgaming schrieb:Wer vor einigen Jahren Nvidia-Aktien gekauft hat, dürfte damit einiges richtig gemacht haben - mit dem Thema hat das aber nach wie vor nichts zu tun. Ein vernünftiger Investor ist nicht gleich ein Fanboy.

Ein ziemlich polemischer Vergleich, da ich bezweifle, dass die meisten Besitzer teurer Grafikkarten diese auf Kosten von Annehmlichkeiten wie ausreichendem Wohnraum anschaffen - aber dabei kann ich natürlich nur von mir selbst sprechen

Danke für deine Ausführliche Antwort. Hat mir sehr gefallen

BobbyFischer

Newbie

- Registriert

- Apr. 2024

- Beiträge

- 1

Hallo, weil viele hier über den Test meckern, warum wieso weshalb mit oder ohne dlss, tsr, hoch , balanced usw.

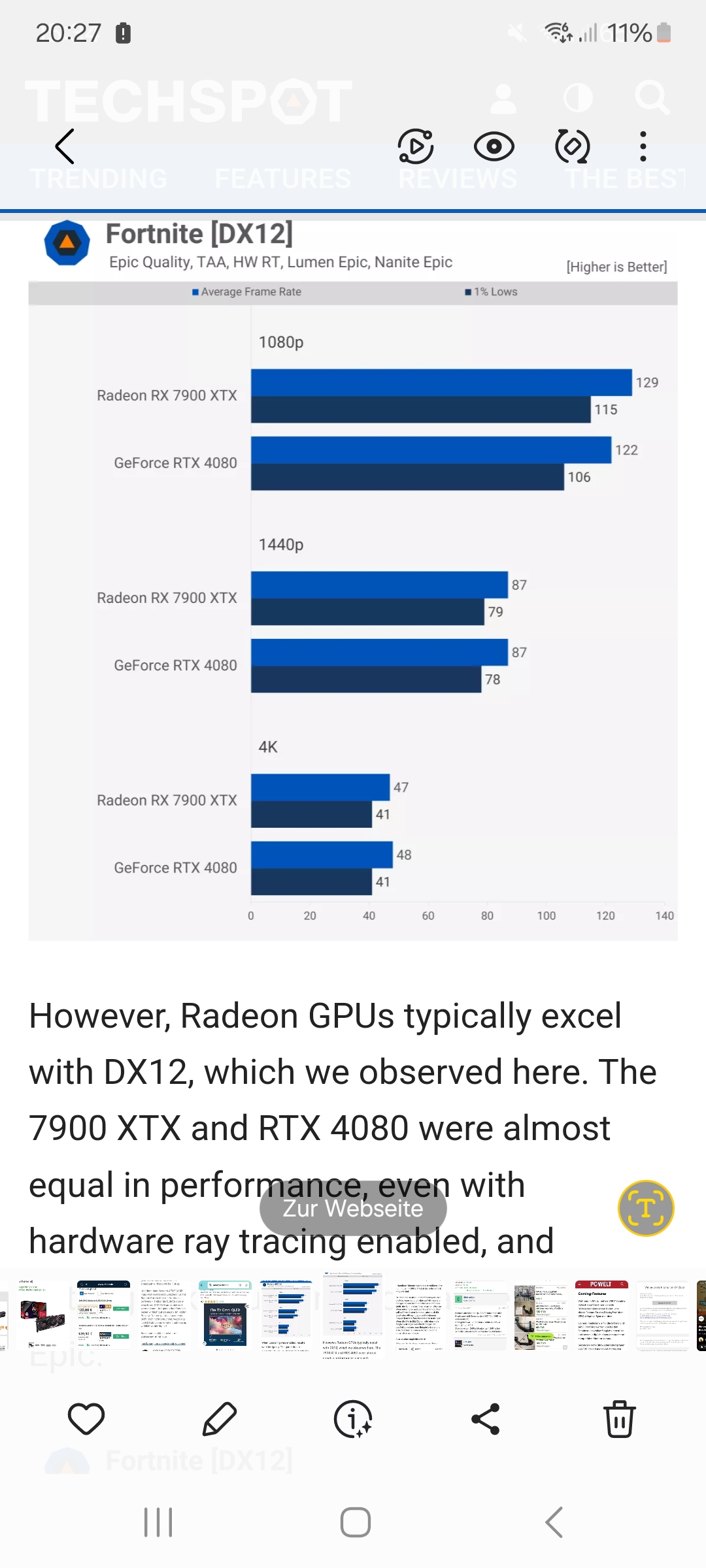

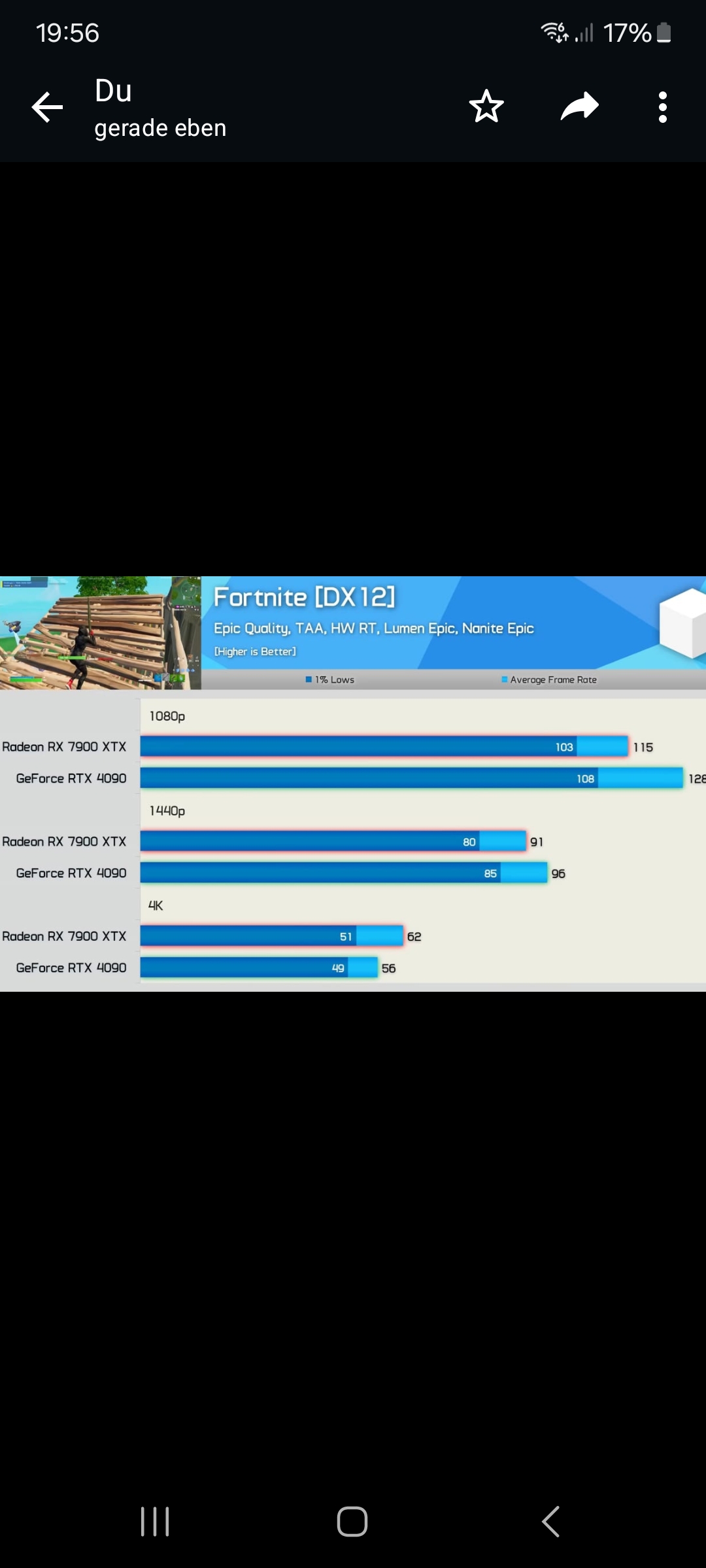

hab hier zwei Test gefunden wo Nativ und alles auf max. inklusive Raytracing getestet wir

Wie man sieht, schaffen selbst die Top GPU's ohne DLLS und TSR auf max Settings, nur lächerlich geringe FPS.Die meisten Menschen haben Mittelklasse GPU's.Deswegen finde ich den Test Realitätstreu und gut.Im Test wurde oft darauf eingegangen das man möglichst 90 FPS haben sollte bei diesem shooter.btw hab mein setting so eingestellt, das ich mein 5120x1440 240hz monitor mit konstant 240fps befeuer.Diese vereinzelte Kritik am Test kann ich nicht nachvollziehen

hab hier zwei Test gefunden wo Nativ und alles auf max. inklusive Raytracing getestet wir

Ergänzung ()

Wie man sieht, schaffen selbst die Top GPU's ohne DLLS und TSR auf max Settings, nur lächerlich geringe FPS.Die meisten Menschen haben Mittelklasse GPU's.Deswegen finde ich den Test Realitätstreu und gut.Im Test wurde oft darauf eingegangen das man möglichst 90 FPS haben sollte bei diesem shooter.btw hab mein setting so eingestellt, das ich mein 5120x1440 240hz monitor mit konstant 240fps befeuer.Diese vereinzelte Kritik am Test kann ich nicht nachvollziehen

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 175

- Aufrufe

- 10.884

- Antworten

- 159

- Aufrufe

- 8.992

- Antworten

- 169

- Aufrufe

- 9.974

- Antworten

- 283

- Aufrufe

- 27.812

- Antworten

- 1.343

- Aufrufe

- 108.717