Majestro1337

Commander

- Registriert

- Sep. 2008

- Beiträge

- 2.844

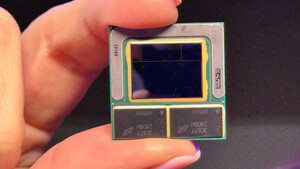

Rockstar85 schrieb:Die CPU macht ja Run to Idle, nur bringt das nichts wenn die Konkurrenz eben 140W verbraucht aber nur 10% langsamer ist.

Die Betrachtung bzw der hurry up and get idle Ansatz von Intel war schon damals fragwürdig, weil er nur dann funktioniert wenn die Energieeinsparung durch das schnellere idlen den Mehrverbrauch aufwiegen, was nur klappt wenn die Infrastruktur in vgl zur cpu viel Energie verbraucht und die cpu nicht sonstwieviel verbrät. Ergo: im notebook. Im Desktop war ich schon immer im Vorteil, wenn ich die cpu im sweetspot ihre Arbeit machen lasse, im laptop mit dem ganzen übersteuern heute auch, aber die Gefühle Leistung für den Benutzer muss eben zunehmen.

Ansonsten würde ich vermuten, dass die Mehrleistung bei den min fps wohl vor allem Verbesserungen am scheduler, der zwischen P und E cores verteilt, zu verdanken sein dürften. Von den zusätzlichen e-cores werden die games wohl kaum profitieren, also kann's ja nur an einer effizienteren ausnutzung der p-cores bzw beider kerntypen liegen